jede autorin und jeder autor nutzt täglich digitale technologie, um texte zu verfassen, zu telefonieren, artikel zu lesen, emails zu versenden, veranstaltungen zu bewerben und für unzählige andere tätigkeiten. dennoch findet wenig reflexion über die auswirkungen dieser technologien auf das schreiben und leben derjenigen statt, die damit professionell arbeiten. das textverarbeitungsprogramm wird als eine etwas leistungsfähigere schreibmaschine angesehen, die hin und wieder wörter rot unterwellt oder unerwartet abstürzt. dass die suchmaschine ergebnisse manchmal seltsam reiht oder absurde vorschläge macht, wird nicht bemerkt oder einfach hingenommen und der treffgenauen werbung auf den webseiten der zeitungen keine beachtung geschenkt. allenfalls wird die verblödung der jugend durch eine neue app1 oder das ende der schriftkultur2 vorausgesagt, über die technokratische sprache der automatischen übersetzungsdienste der internetkonzerne gelacht und auf den nächsten artikel im algorithmisch3 kuratierten nachrichtenstrom geklickt.

abseits dieser oberflächlichen und kulturkonservativen betrachtungen findet in der deutschsprachigen literatur die gegenwärtige »linguistische wende« in der informationstechnologie kaum widerhall. aufgrund einer fast pathologischen literaturbetriebsblindheit scheint es wenige schreibende zu interessieren, dass die automatisierung einzelner journalistischer felder bevorsteht, smartphones sprechen und zuhören gelernt haben und weshalb internetkonzerne milliarden in sprachtechnologie investieren.

aber sollte nicht gerade die poesie die bedingungen und strukturen eines sprachmediums spielerisch hinterfragen? desjenigen mediums, das aus symbolen und wörtern, kommunikationsprotokollen und dialogen besteht? wäre das nicht die ureigene domäne der literatur? warum scheuen die dichterinnen und dichter davor zurück? ist der grund die von Hannes Bajohr beschriebene »Furcht vorm Digitalen«? das noch immer zu weit verbreitete bild vom romantischen dichter, der nicht an wissenschaft und technik anstreifen möchte? der stolz darauf ist, von mathematik nichts zu verstehen, weil sie als kunstfern gilt? oder ist das eine generationenfrage? ein ausbildungsproblem?

einzelne oder kleine gruppen, die sich mit diesen themen auseinandersetzen und subversive umdeutungen der digitalen werkzeuge vornehmen, wie beispielweise das textkollektiv für digitale literatur 0x0a oder der »paradoxical print publisher« TRAUMAWIEN, gibt es auch im deutschsprachigen raum. im literaturbetrieb sind sie aber außenseiter.

programm

datenpoesie ist der arbeitstitel meines eigenen projektes, das jene sprachtechnologien auslotet, die vielleicht in zukunft unsere interaktion mit digitalen systemen bestimmen werden. dazu bediene ich mich methoden der künstlerischen forschung und der explorativen programmierung, die im gegensatz zur wissenschaftlichen forschung und zur ingenieursmäßigen informatik den subjektiven aspekt, den künstlerischen wert und den persönlichen erkenntnisgewinn betonen.

ich verwende algorithmen und ideen der zeitgenössischen computerlinguistik und versuche sie nachzuvollziehen und umzusetzen, indem ich daraus eine poetische versuchsanordnung programmiere. dabei interessieren mich die technischen und soziokulturellen bedingungen, die zu erfüllen sind. welches konzept von sprache wird vorausgesetzt? wie funktioniert die maschine? welchen beschränkungen ist das programm unterworfen? was passiert, wenn ich etwas verändere? wenn ich bewusst gegen die regeln verstoße, die für einen reibungslosen ablauf einzuhalten sind? kann ich so die verborgenen strukturen und neigungen der ursprünglichen programmierer zu tage fördern?

durch das steigende interesse der wirtschaft an linguistischen algorithmen sind in den letzten jahren zahlreiche anwendungen und werkzeuge entstanden, die ich zum teil direkt oder in einer abgewandelten form nutzen kann. zum anderen verwende ich vorgangsweisen aus anderen feldern wie biologie und physik, wenn sie sich erfolgversprechend in einer poetischen arbeit einsetzen lassen.

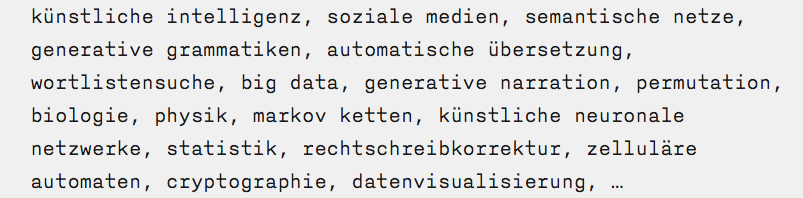

mögliche themenbereiche, algorithmen und felder sind dabei:

im folgenden möchte ich drei beispiele für meine explorative beschäftigung mit zeitgenössischen linguistischen technologien geben.

stoppwörter

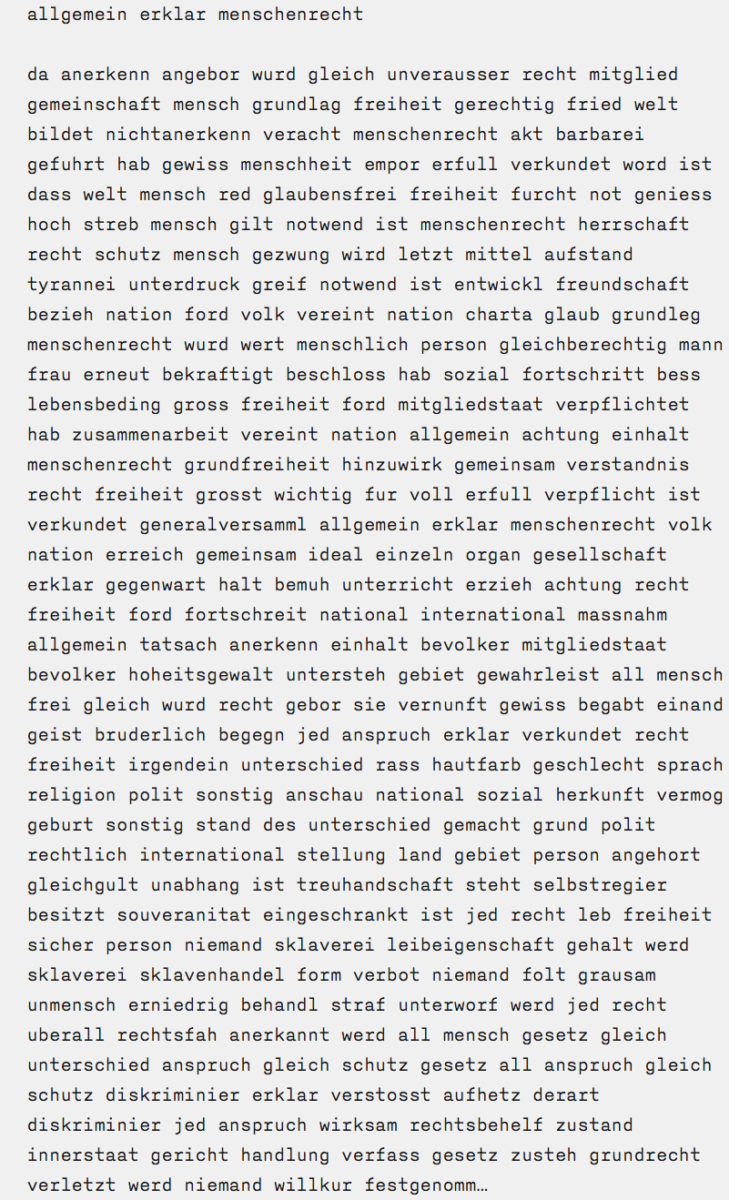

die sprachverarbeitungsalgorithmen der internetsuchmaschinen sind eigentum und geschäftsgeheimnis der hersteller und daher einer kritischen betrachtung schlecht zugänglich. dennoch gibt es hinweise über grundlegende funktionen, wie beispielsweise die anfängliche normalisierung des zu durchsuchenden textes. diese funktion dient der vereinheitlichung und der datenreduktion, da eine suchmaschine wie google nach möglichkeit alle webseiten4 in einem suchindex zusammenfassen will und daher gezwungen ist, speicher zu sparen.

so werden aus dem text der zu untersuchenden homepage als erstes sogenannte stoppwörter entfernt, die der algorithmus als nicht relevant für den zu erstellenden suchindex betrachtet. das sind artikel, präpositionen, konjunktionen und andere häufige wörter. in einem zweiten schritt werden alle verbliebenen wörter auf ihren wortstamm zurückgestutzt, was zum einen ebenfalls der datenreduzierung, zum anderen der verallgemeinerung des zu erstellenden suchverzeichnisses dient. wenn so beispielsweise das wort »allgemeine« auf den wortstamm »allgemein« reduziert wird, kann dieser begriff dann mit den wortformen »allgemeine«, »allgemeines«, »allgemeiner« etc. gefunden werden. abschließend werden noch alle satzzeichen entfernt und der resultierende text zur indizierung an das nächste programmmodul weitergereicht.

das ergebnis der anwendung der obengenannten schritte auf den beginn der allgemeinen erklärung der menschenrechte ergibt einen text, der das reduzierte sprachverständnis der suchmaschine verdeutlicht:

angesichts der verstümmelten sprache5 drängt sich die frage auf, wieviel vom ausgangstext in der suchmaschinenversion erhalten bleiben kann und ob nicht die sprachalgorithmen auf die morphologisch ärmere englische sprache optimiert wurden.

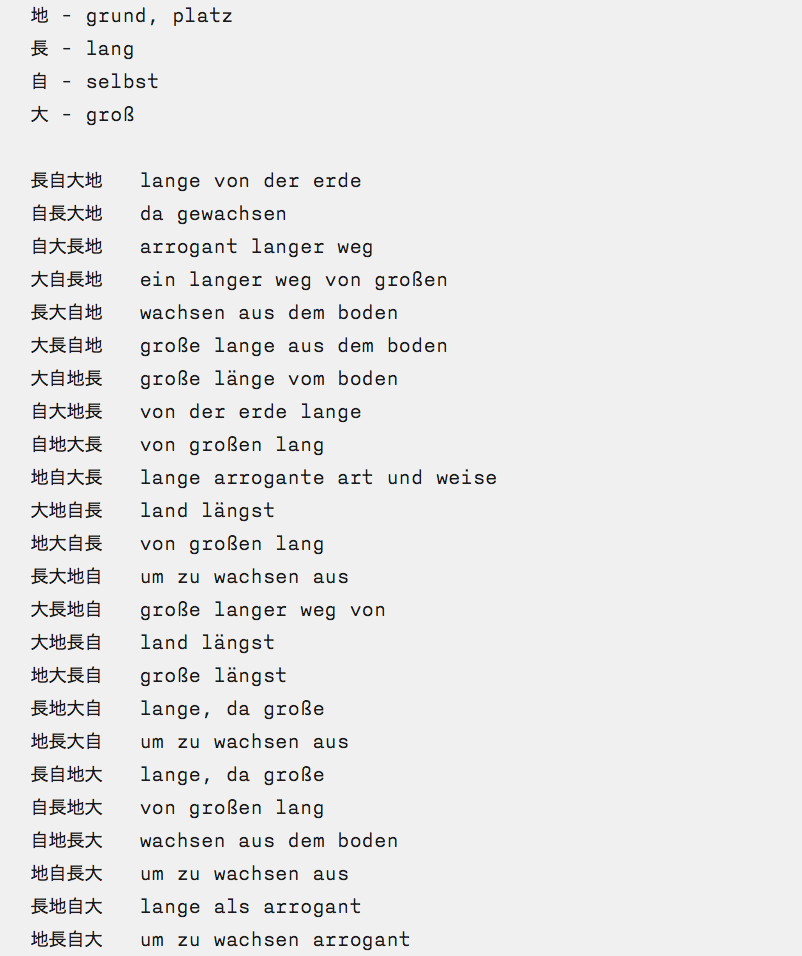

übersetzung

jeder, der sich im netz bewegt, trifft früher oder später auf automatisch übersetzte texte – sei es in spammails oder durch eigene versuche mit übersetzungsprogrammen. die unzulänglichkeiten der maschinellen bearbeitung sorgen dabei oft für unfreiwillige komik und wurden als klassiker der automatischen sprachverarbeitung schon des öfteren zur erzeugung experimenteller literatur genutzt. mein ansatz zur erforschung der poetischen möglichkeiten ist ein systematischer und kombinatorischer. inspiriert durch die permutationsgedichte Brion Gysins entwarf ich ein permutatives übersetzungssprachspiel. aus einer liste der 100 häufigsten logografischen japanischen schriftzeichen (kanji) wählt das programm zufällig vier symbole aus und ordnet sie permutativ in 24 zeilen an. dieses pseudojapanische gedicht wird dann anschließend von einem automatischen übersetzungsprogramm ins deutsche übertragen.

ein beispiel:

die stellenweise wenig poetische sprache in kombination mit der variierenden wiederholung erzeugen eine spannung zwischen der maschinenästhetik und der sprachlichen form. hin und wieder scheinen in diesen gedichten die ursprungstexte der sprachcorpora durch, mit denen die übersetzungsprogramme trainiert wurden wie z.b. die aus mehrsprachigen parallelübersetzungen, die redetexten des europäischen parlaments entnommen wurden.

lernen

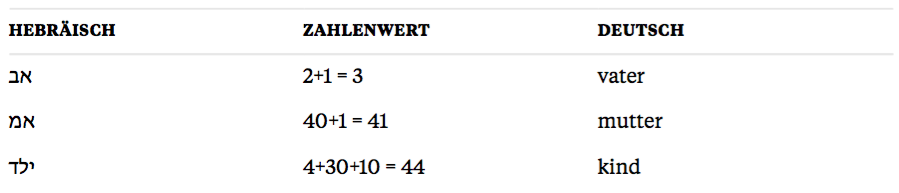

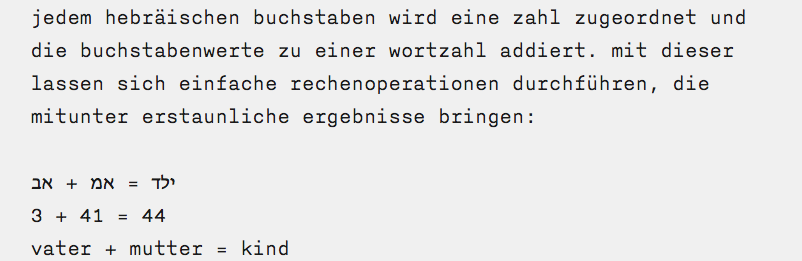

seit den ersten experimenten zur automatischen verarbeitung menschlicher sprache brachte die unschärfe von wortbedeutungen viele versuche zum scheitern, die darauf abzielten, begriffe exakt zu definieren. dieses problem, das Ludwig Wittgenstein als familienähnlichkeit6 bezeichnet, entzieht die begriffe einer taxonomischen klassifizierung und somit einer simplen logisch-symbolischen modellierung in einem computerprogramm. in den letzten jahren entstanden allerdings vielversprechende methoden7, den kontext von wörtern zu berücksichtigen und so das problem der unscharfen begriffe zu umgehen. dazu wird ein sogenanntes künstliches neuronales netz, das einem verbund von gehirnzellen nachempfunden ist, mit sätzen eines textes gefüttert, woraus dieses dann autonom für jedes wort eine zahlenreihe8 lernt, die den kontext des wortes in relation zu den anderen wörtern des textes angibt. die idee, wörter als zahlen zu kodieren, ist nicht neu, so wurden beispielsweise in der mystischen tradition der kabbala rechnungen wie die folgende angestellt:

mit den säkularen zahlenreihen der computerlinguisten lassen sich ähnliche operationen durchführen:

![]()

im gegensatz zur kabbala sind hier allerdings keine »mystischen verbindungen« verantwortlich für das erstaunliche ergebnis, sondern ein sorgfältig trainiertes computerprogramm, das anhand der wortkontexte auf analogien schließen kann, ohne dass es explizite vorabinformation über die wortbedeutung benötigen würde. das programm lernt die wortzusammenhänge und damit eine art rudimentäres allgemeinwissen selbständig aus einem umfangreichen ausgangstext9.

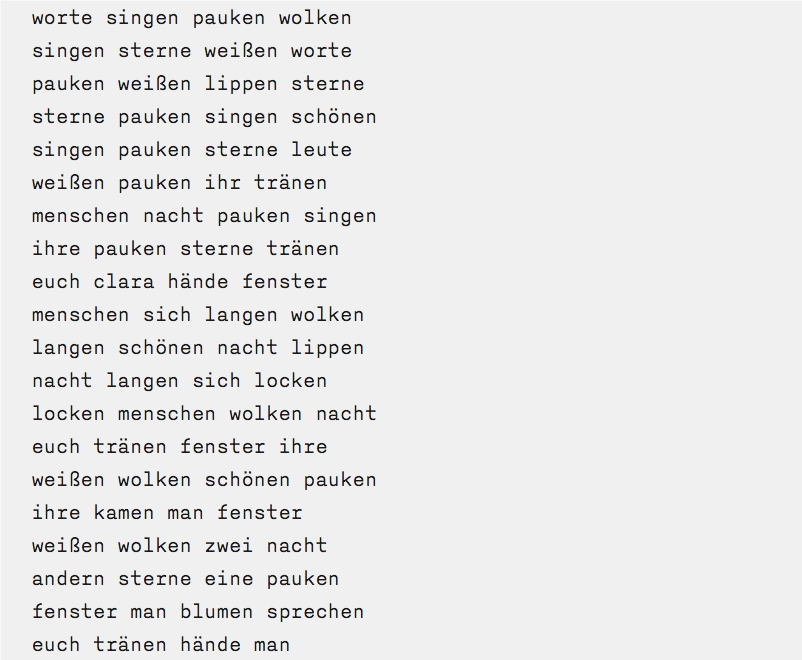

für meine poetischen zwecke lasse ich das programm die gedichte Heinrich Heines lernen und dann ausgehend vom begriff »worte« 20 neue wörter ermitteln, die sich in den gedichten in kontextualer nähe des begriffs befinden. zu jedem dieser 20 wörter sucht das programm wiederum 4 naheliegende, woraus sich dann automatisch dieses 80 wörter umfassende gedicht ergibt:

die begriffswelt Heines lässt sich klar in den zeilen erkennen und führt zum verdacht, ob sich nicht auch in anderen vorgeblich objektiveren anwendungen derselben methode die ausgangstexte zumindest in spuren wiederspiegeln und das nicht eine allgemein angenommene und erwünschte objektivität von sprachverarbeitenden algorithmen verunmöglichen könnte.

fragen

schon diese drei beispiele aus meinem projekt werfen also einige fragen auf: – wer kontrolliert und reguliert die algorithmen, die die fast monopolartigen internetdienste steuern? – aus welchen quellen speisen sich die daten, die für die sprachverarbeitung benötigt werden? – welches sprachverständnis liegt ihnen zugrunde? – welche politischen und gesellschaftlichen einstellungen werden durch die wahl der ausgangstexte für selbstlernende programme mitkodiert? – kann es überhaupt objektive algorithmen geben? oder müsste manchen programmen nicht zumindest eine partielle urheberschaft zugestanden werden, um ihre subjektivität herauszustreichen?

diese und weitergehende problemfelder künstlerisch zu untersuchen, ist die intention meiner ständig wachsenden sammlung an datenpoemen und programmierten texten. ich möchte nicht über technologie schreiben, sondern mit ihr und in ihr arbeiten. genauso wie das sprachspiel erkenntnisse über die sprache bringen kann, so vermag vielleicht die explorative erforschung der sprachtechnologie aufschluss über die verfasstheit und die abschätzung möglicher gesellschaftlicher folgen zu geben.

mehr zum projekt hier.

1Die digitale Spaßkultur macht dumm

2Günther, Markus: »Nur noch Analphabeten«, Frankfurter Allgemeine Sonntagszeitung – FAS, 25. Mai 2014, S. 2

3»Ein Algorithmus ist eine eindeutige Handlungsvorschrift zur Lösung eines Problems oder einer Klasse von Problemen« (Wikipedia). ein alltagsbeispiel wäre das kochen eines weichen eis (koche das ei, bis 4 minuten und 45 sekunden vergangen sind). oder die schriftliche division, wie sie in der schule gelehrt wird.

4zur zeit mehr als 1.000.000.000 laut internetlivestats

5oder nach Ernst Jandl »heruntergekommene sprache«

6Ludwig Wittgenstein: Philosophische Untersuchungen 66.

7z.b. Word2vec

8ein vektor mit einigen hundert dimensionen

9im obigen beispiel ist dies der text der gesamten wikipedia

Das Startbild beruht auf einer Arbeit von Jörg Piringer